我正在寻找方法将浮点值的可变长度序列嵌入到固定大小的向量中。所述输入格式如下:TensorFlow:如何将浮点序列嵌入固定大小的向量?

[f1,f2,f3,f4]->[f1,f2,f3,f4]->[f1,f2,f3,f4]-> ... -> [f1,f2,f3,f4] [f1,f2,f3,f4]->[f1,f2,f3,f4]->[f1,f2,f3,f4]->[f1,f2,f3,f4]-> ... -> [f1,f2,f3,f4] ... [f1,f2,f3,f4]-> ... -> ->[f1,f2,f3,f4]

每一行是一个可变长度sequnece,具有最大长度60在一个sequece每个单元为4的浮点值的元组。我已经将零填充为所有序列长度相同。

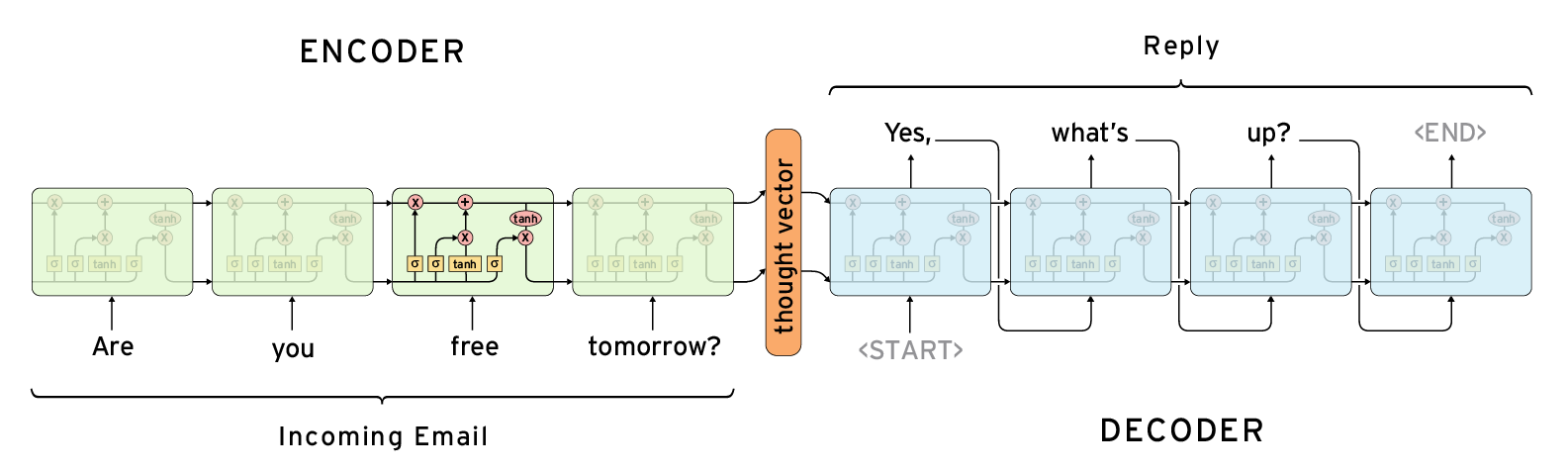

下面的架构似乎解决了我的问题,如果我使用输出作为输入相同,我需要在中心思想矢量作为序列的嵌入。

在张量流程中,我发现了两种候选方法tf.contrib.legacy_seq2seq.basic_rnn_seq2seq和tf.contrib.legacy_seq2seq.embedding_rnn_seq2seq。

但是,这些方法似乎被用来解决NLP问题,输入必须是词的离散值。

那么,是否还有其他功能来解决我的问题?

,

,

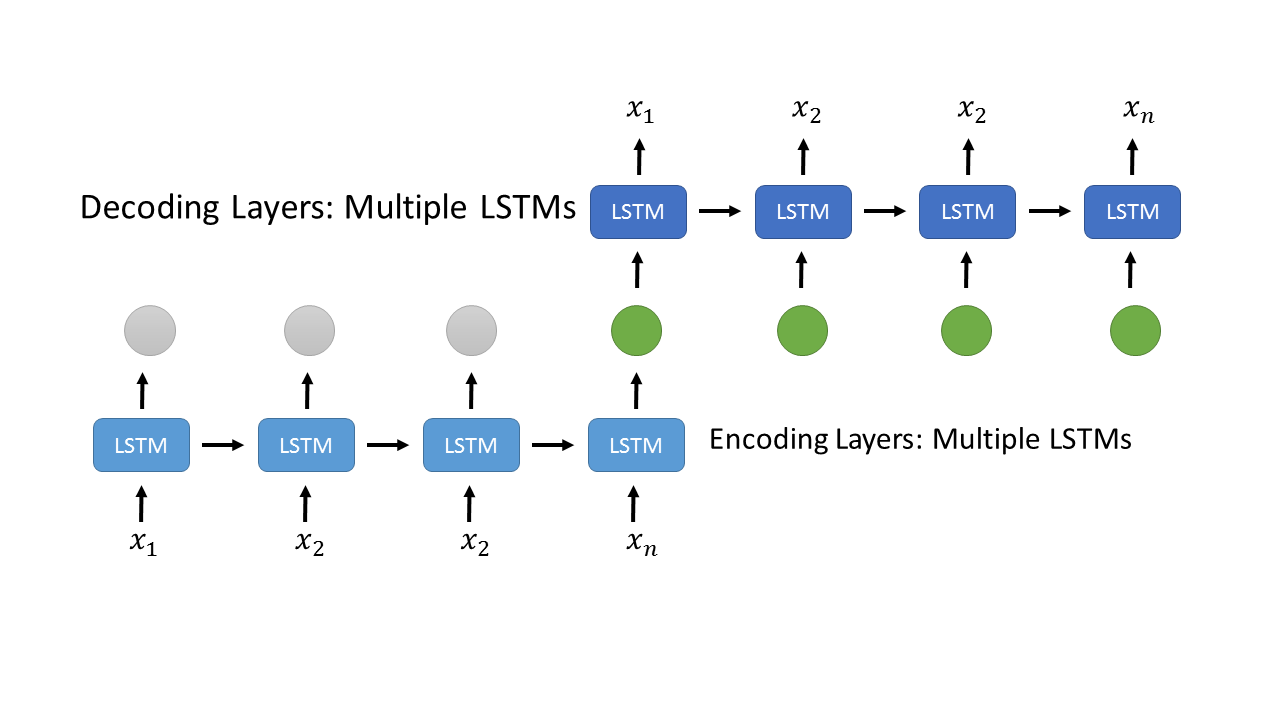

你的意思是你需要一个[复发层(https://www.tensorflow.org/api_guides/python/nn#Recurrent_Neural_Networks),如[LSTM(HTTPS: //www.tensorflow.org/api_docs/python/tf/contrib/rnn/LSTMCell)或[GRU](https://www.tensorflow.org/api_docs/python/tf/contrib/rnn/GRUCell)?这通常用于生成一个依赖于可变数量的固定尺寸输入的矢量(实际上,您的图片似乎具有LSTM单位)。 – jdehesa